目录

🎯 核心发现:AI 的回答是免费的!只有你的问题消耗请求次数! 这意味着要让 AI 在一次回答中给你最完整、最详细的解决方案。

先搞清楚这玩意儿到底咋收费的

咱们先把 cursor 的计费规则理清楚,不然花了钱还不知道自己买了啥,那不是冤大头吗?

基础计划对比

免费版

- 给你 2 周 Pro 试用

- 每月 2000 次代码补全

- 50 次慢速高级请求

- 基本够你体验个感觉

Pro 版($20/月)

- 无限代码补全

- 500 次快速高级请求

- 无限慢速请求

- 可以用 Background Agents 和 Bug Bot

Ultra 版($200/月)

- Pro+的所有功能

- 用量限制提高 20 倍

- 土豪专用

团队计划

Teams 版($40/用户/月)

- 每个用户 500 次高级模型请求

- 无限免费模型请求

- 团队管理功能

其实核心就是这个500 次快速高级请求,用完了要么等(慢速请求),要么加钱(启用按使用量付费)。

计费核心机制解析

核心概念:请求 vs 模式

请求(Request)是什么?

- 每个请求 = 一次与模型的完整交互

- 包含:用户消息 + 代码上下文 + 模型响应

- 不同模型消耗不同数量的请求

- Pro/Business 计划每月包含 500 次请求

两种模式:

普通模式(按请求次数):

- 适合大多数日常任务

- 按固定请求次数计费,每次请求费用约 $0.04 ≈ ¥0.29

- 用户每发送一条消息 = 1 次请求

- 无论内容长短都按次数计费

- 重点:AI 的响应内容完全免费!

- 上下文优化不影响计费

- 示例:一次包含 2 条用户消息的对话 = 消耗 2 次请求

- 一次请求里面最多调用 25 次工具,超了之后会提示你需要算一次新请求

Max 模式(按 Token 计费):

- 适合复杂任务和大上下文

- 按 Token 实际使用量计费

- 支持超大上下文(最高 100 万 Token)

- 最多支持 200 次工具调用

- 读取文件最多 750 行

- 价格计算 = 底层模型 API 价格 + 20%Cursor 平台服务费

关键点: 普通模式下 AI 的回答是免费的!只有你的问题消耗请求次数。这彻底改变了我们的使用策略!

实战攻略:如何最大化 500 次请求

策略 1:选对模型,事半功倍

不同模型消耗的请求数不一样。想想看,你是要用顶配的 Claude Sonnet 4 Think 处理简单问题,还是用 Claude Sonnet 4 处理日常任务?因为 Claude Sonnet 4 Think 是按照 request * 2 算的

野路子建议:

- 简单的代码补全 → 用 免费模型 cursor-small

- 复杂的重构 → 用 Claude Sonnet 4 Think(消耗多,但值得)

- 日常 debug → 用 Claude Sonnet 4

问问自己:

- 这个任务真的需要最强的模型吗?

- 能不能先用轻量模型试试?

策略 2:批量处理,一次搞定

既然 AI 的回答是免费的,那我们就要充分利用这个特点!

错误做法:

展开代码请求1:这个函数有什么问题? 请求2:怎么修复? 请求3:能优化一下吗? 请求4:加个错误处理?

正确做法:

展开代码一次性请求:请分析这个函数的问题,提供修复方案,优化性能,并添加错误处理。 同时给出完整的代码示例、测试用例、性能对比分析,以及可能的替代方案。

为什么这样做?

- 4 个请求变成 1 个(省了 3 次请求)

- AI 可以给你写 10 页的详细分析(完全免费!)

- 一次性获得完整解决方案

关键思路: 让 AI 在一次回答中给你尽可能多的信息,因为回答的长度不花钱!

策略 3:榨干 AI 的回答价值

既然 AI 的回答是免费的,那就让它给你提供最大价值!

低价值问法: "这个函数有什么问题?"

高价值问法: "请详细分析这个函数的问题,包括:

- 代码逻辑问题分析

- 性能瓶颈识别

- 安全漏洞排查

- 完整的修复方案

- 优化后的代码实现

- 单元测试用例

- 性能对比数据

- 最佳实践建议

- 可能的替代方案

- 相关的代码规范建议"

效果对比:

- 第一种:得到简单回答,可能还需要追问

- 第二种:得到一份完整的代码审查报告!

记住: AI 愿意给你写多长的回答都不收费,所以要充分利用这个特点!

策略 4:善用上下文,减少重复

cursor 有个牛逼的功能就是记住上下文。别每次都从头开始解释。

低效做法: 每次都重新介绍项目背景,重新解释需求

高效做法: 建立一个会话,持续在这个会话里工作,让 AI 记住你的项目

策略 5:免费功能优先

记住,不是所有功能都消耗你的 500 次请求:

不消耗请求的功能:

- Tab 自动补全(这个是 cursor 自己的模型)

- 基础的代码高亮

- 语法检查

消耗请求的功能:

- 复杂的 agent 对话

- 代码重构建议

- 复杂的 debug 分析

策略 6:用好慢速请求

500 次用完了?别急着付钱!

慢速请求虽然要等,但:

- 功能完全一样

- 只是排队时间长点

- 适合不紧急的任务

实用技巧:

- 临下班的时候提交慢速请求

- 处理不紧急的代码审查

- 学习新技术的时候用慢速请求

策略 7:监控使用情况

去 cursor.com/dashboard 看看你的使用情况。

关键指标:

- 还剩多少次请求?

- 哪种模型用得最多?

- 什么时候用完的?

根据这些数据调整你的使用策略。

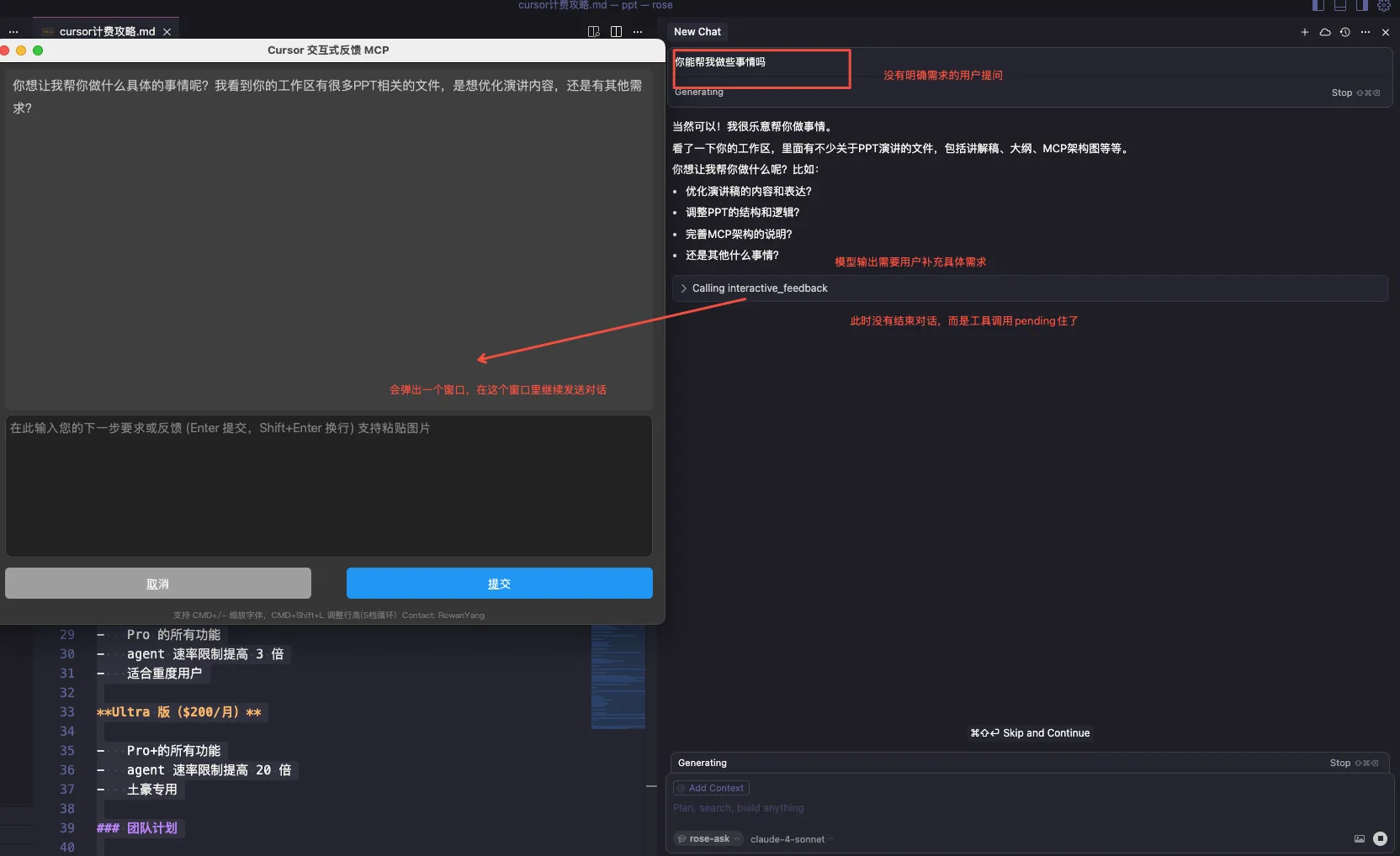

终极神器 - Interactive Feedback MCP

有个叫 interactive-feedback-mcp 的工具,可以让你的 500 次请求变成 2500 次效果!

它的原理超级巧妙:

- AI 在完成任务前会先问你:"这样对吗?"

- 你可以在同一个请求内进行多轮反馈

- 工具调用不算作单独的请求!

实战效果:

展开代码传统方式: 请求1:写个用户注册功能 请求2:不对,我要加邮箱验证 请求3:还要加密码强度检查 请求4:错误提示要中文的 用了MCP后: 请求1:写个用户注册功能 (做完之后调用Interactive Feedback弹出窗口)你可以接着提需求 (在同一个请求内完成所有澄清)

看到了吗?4 个请求变成 1 个,而且质量更高!

图示:

- 使用前

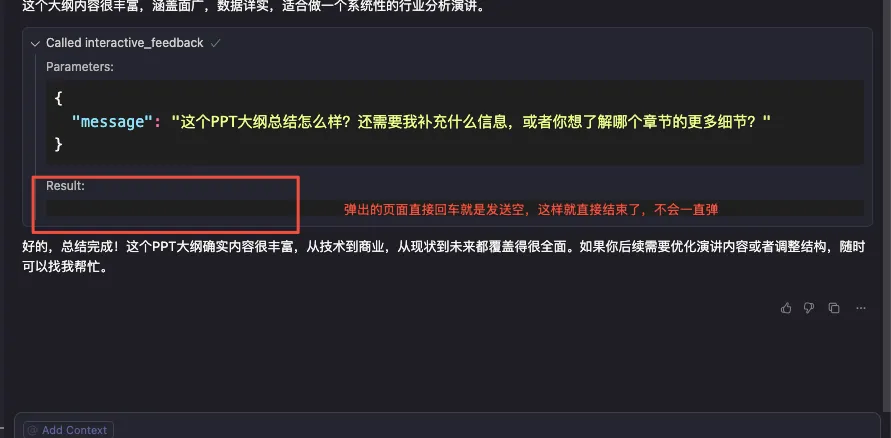

2. 使用后

2. 使用后

最后如果不需要再补充或者继续对话了,直接发送空就行

如何配置:

如何配置:

第一步:安装依赖

bash展开代码# 安装 Python 包管理器 uv

# Windows:

pip install uv

# Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

# macOS:

brew install uv

第二步:获取代码

bash展开代码git clone https://github.com/Rosersn/interactive-feedback-mcp.git

第三步:配置 cursor

在你的 mcp.json 文件中添加(记得改成你的实际路径):

json展开代码{

"mcpServers": {

"interactive-feedback": {

"command": "uv",

"args": ["--directory", "[这里改成你的路径]/interactive-feedback-mcp", "run", "server.py"],

"timeout": 600,

"autoApprove": ["interactive_feedback"]

}

}

}

第四步:设置 AI 规则 在 cursor 的 Settings > Rules > User Rules 中添加:

展开代码每次回答结束必须调用interactive_feedback去收集我的反馈,如果反馈为空,则结束这轮对话。 如果需求不明确,请使用 interactive_feedback 进行澄清提问后再继续。

遇到问题? 如果启动失败,在终端执行安装命令看看报什么错,一般是 Python 环境问题。

配置好之后,AI 就会养成"问清楚再做"的好习惯,而不是瞎猜浪费你的请求。

MCP 工具推荐:

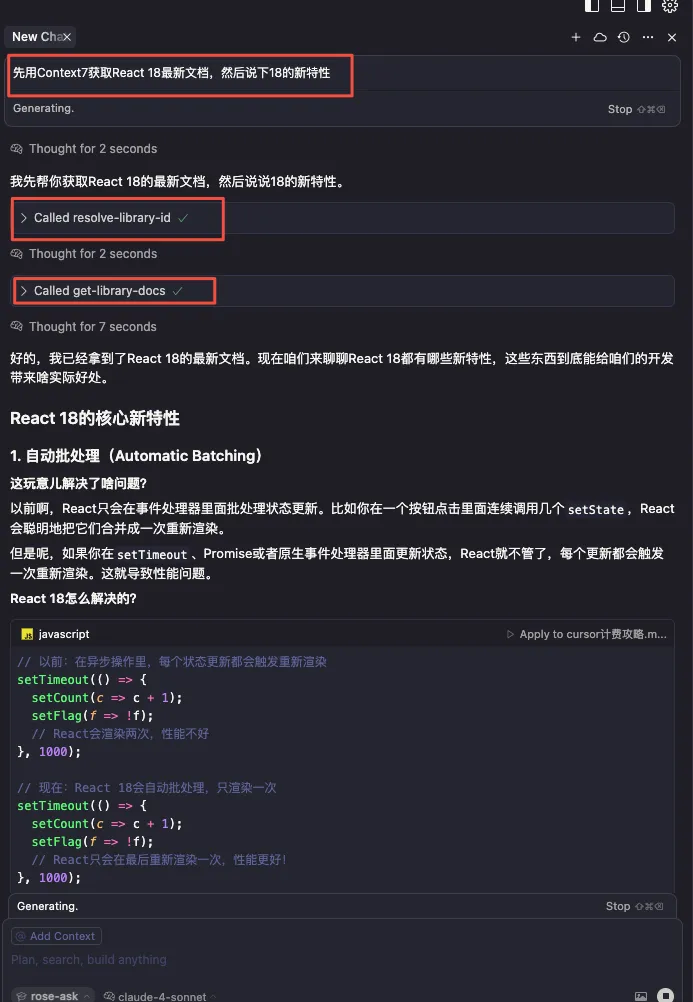

Context7 - 告别过时代码和幻觉 API

Context7 是个解决 AI"胡说八道"问题的神器!

它解决什么问题?

- AI 生成基于旧训练数据的过时代码

- 生成不存在的"幻觉"API

- 针对旧软件包给出过于笼统的答案

它怎么帮你省请求?

- 一次性获取最新、准确的文档信息

- 避免因为过时信息导致的多次修正

- 减少"这个 API 不存在"的尴尬

配置方法:

在你的 mcp.json 中添加:

json展开代码{

"mcpServers": {

"context7": {

"command": "npx",

"args": ["-y", "@upstash/context7-mcp"]

}

}

}

使用方法:

展开代码错误做法:直接问"怎么用React 18的新特性?" 正确做法:先用Context7获取React 18最新文档,再问具体问题

实战效果:

- 原来:问了 3 次还是过时信息,浪费 3 个请求

- 现在:一次获取最新信息,直接得到准确答案

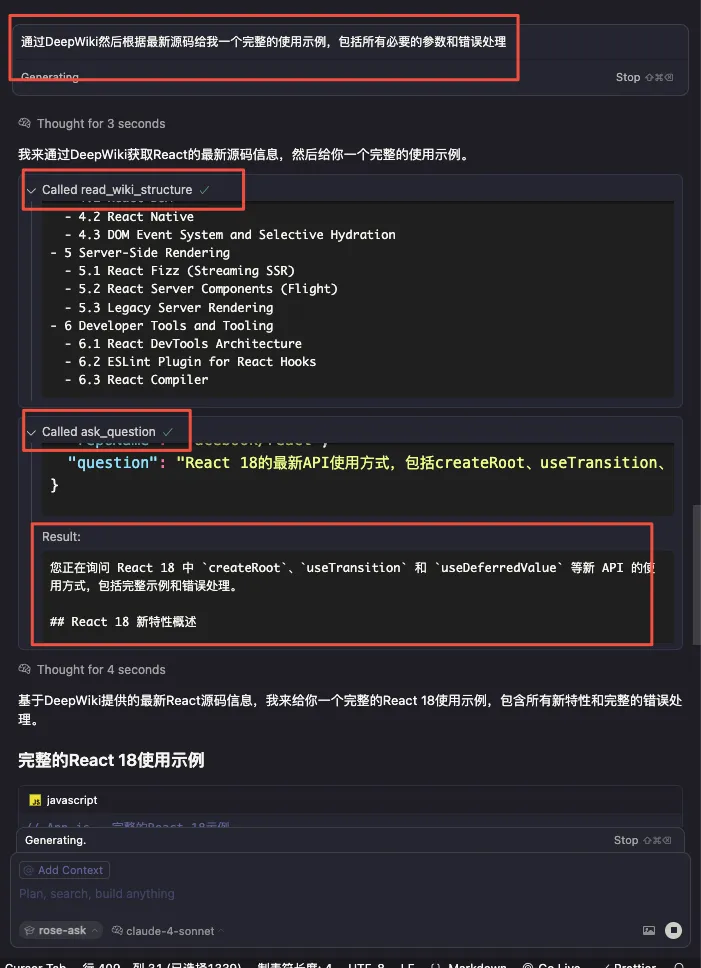

DeepWiki - 把 GitHub 项目变成聊天机器人

DeepWiki 让你直接和 GitHub 项目"对话"!

它的神奇之处:

- 基于 GitHub 仓库源代码生成最新文档

- 由 Devin 驱动,理解代码结构

- 直接问问题,不用翻文档

使用方法超简单:

- 看到 GitHub 项目:

https://github.com/cloudwego/eino - 改成 DeepWiki:

https://deepwiki.com/cloudwego/eino - 直接问问题!

配置方法:

在你的 mcp.json 中添加:

json展开代码{

"mcpServers": {

"deepwiki": {

"url": "https://mcp.deepwiki.com/mcp"

}

}

}

它怎么帮你省请求?

- 直接从源码生成文档,信息最新最准确

- 避免因为文档过时导致的多次试错

- 一次性了解整个项目架构

实战场景:

展开代码传统方式: 请求1:这个开源项目怎么用? 请求2:我按你说的做了,但是报错了 请求3:能给个完整的例子吗? 请求4:这个API参数是什么意思? 用DeepWiki: 直接问:通过DeepWiki然后根据最新源码给我一个完整的使用示例,包括所有必要的参数和错误处理

三个 MCP 工具组合使用:

- Interactive Feedback - 让 AI 问清楚再做

- Context7 - 获取最新准确信息

- DeepWiki - 直接和项目对话

这三个工具一起用,你的 500 次请求能相对于之前的几千次请求,效果提升巨大!

实战公式

效率 = 问题质量 × 回答价值榨取度 × 上下文完整度 × 模型选择正确度

关键变量解释:

- 问题质量:问题越详细具体,AI 理解越准确

- 回答价值榨取度:既然回答免费,就要让 AI 给你最完整的答案

- 上下文完整度:提供足够背景信息,减少来回确认

- 模型选择正确度:简单任务用轻量模型,复杂任务用高端模型

总结

cursor 的计费模式其实挺良心的,关键是要会用。500 次请求看起来不多,但如果你:

- 选对模型

- 批量处理问题

- 充分榨干 AI 的回答价值

- 善用上下文

- 优先使用免费功能

- 合理利用慢速请求

- 监控使用情况

完全够用一个月的。

注意:max 模式是按照 token 数换算成 request 数的,所以上面攻略不适用,在 max 模式下,要想省钱就需要从减少 token 数入手。

最重要的发现: AI 的回答是免费的!所以要让它在一次回答中给你最完整、最详细的解决方案。

最后问问你:你现在用 cursor 最头疼的是什么?是请求不够用,还是不知道怎么问好问题?

完整 MCP 配置示例

为了方便大家一次性配置好所有三个神器,这里提供完整的 mcp.json 配置:

json展开代码{

"mcpServers": {

"interactive-feedback": {

"command": "uv",

"args": ["--directory", "[你的路径]/interactive-feedback-mcp", "run", "server.py"],

"timeout": 600,

"autoApprove": ["interactive_feedback"]

},

"context7": {

"command": "npx",

"args": ["-y", "@upstash/context7-mcp"]

},

"deepwiki": {

"url": "https://mcp.deepwiki.com/mcp"

}

}

}

配置完成后,记得重启 cursor,然后享受你的 3000 次请求效果吧!

Cursor 最新计费模式默认为按照 token 来了,要想使用上述的技巧,需要在 cursor 网页设置里面退回到老的计费模式

小贴士:别忘了 cursor 还有 2 周免费试用,先试用再决定要不要升级 Pro。试用期间好好体验一下,找到适合自己的使用模式。

本文作者:Rose

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!